En hundra år gammal pedagogisk teori som lyfter AI som tankepartner

| språkmodeller | pedagogik | lärande | Lästid: 7 minuter (6598 tecken)

“Förklara så att en tioåring förstår!” En hundra år gammal pedagogisk modell i kombination med en teori om språkmodeller har hjälpt mig i mina funderingar på hur jag bäst använder ChatGPT, Claude och Gemini som bollplank och för att lära nytt – utan att förlora förmågan att “flyga med rumpan”.

Mind the gap – både i Londons tunnelbana och när du använder språkmodeller. Foto: Claudio Schwarz, på Unsplash.

Min fru Anna är förskolepedagog. Hon har många gånger beskrivit hur en av hennes främsta uppgifter är att möta förskolebarnen precis bortom det som de själva kan och klarar av, för att guida dem vidare mot nya förmågor och kunskaper.

Det pedagogiska arbetet bygger på teorin om den proximala utvecklingszonen, formulerad av den sovjetiska psykologen Lev Vygotskij på tidigt 1900-tal. Han definierade den som “skillnaden mellan vad en individ klarar av att göra utan hjälp och vad den kan uppnå med hjälp och stöd”.

Ett av de senaste avsnitten av New York Times teknikpodd Hard Fork, A.I. School Is in Session: Two Takes on the Future of Education, kopplade ihop det Anna berättat om Vygotskij med användning av generativ AI.

I podden hörs några studenter som beskriver hur de använder AI i sina studier. En av dem beskriver en situation som jag tror att många som pluggat på högskola eller universitet känner igen sig i: Att sitta i en stor föreläsningssal och inte alls hänga med i det som professorn säger framme vid whiteboarden. Gapet mellan det man själv kan och det som sägs är för stort, eftersom föreläsaren inte har mött åhörarna i deras proximala utvecklingszoner.

När mentorn inte längre är en människa #

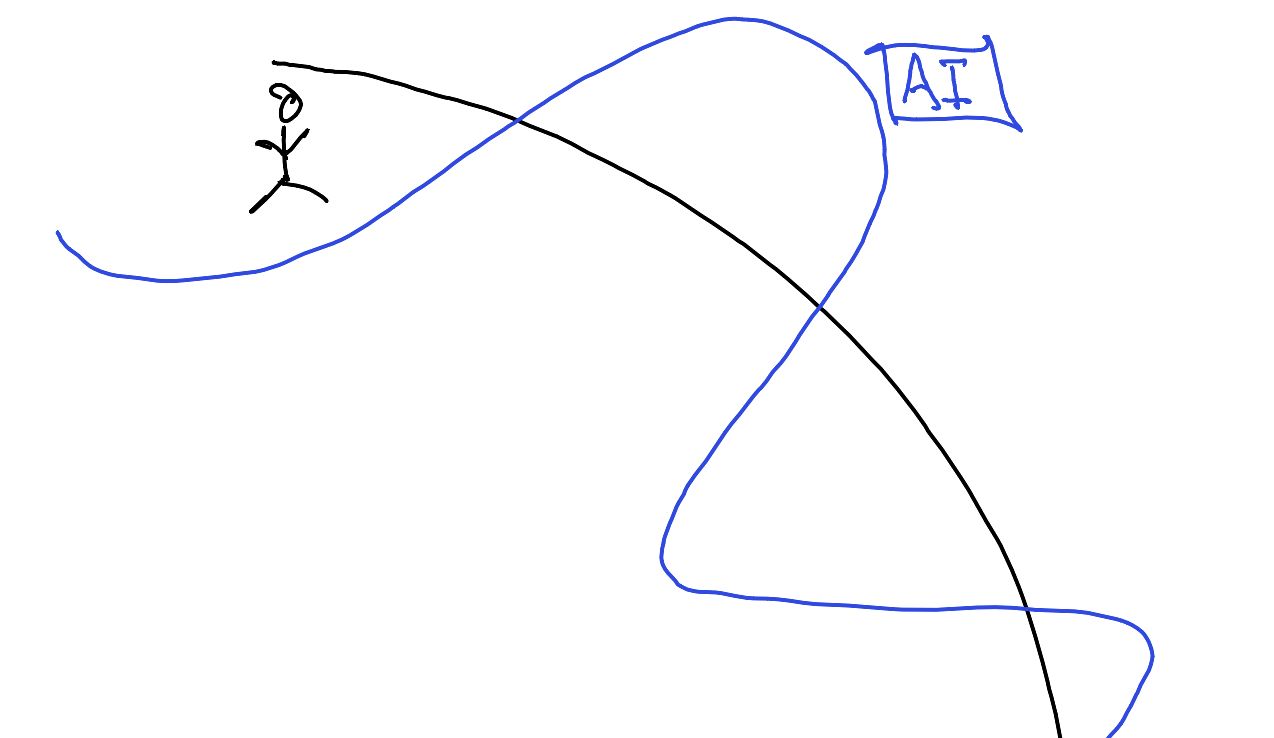

Ethan Mollick är professor på Wharton School vid University of Pennsylvania. På sin blogg och i boken Co-Intelligence har beskrivit vad han ser som generativ AI:s “jagged frontier”. Den här ojämna kanten är Mollicks sätt att beskriva hur stora språkmodeller ibland överraskar oss som otroligt kompetenta och ibland häpnadsväckande dåliga. Den kan skriva fantastisk poesi, men kan inte räkna antalet stavelser.

Den mänskliga förmågan illustrerad av den svarta linjen, den artificiella intelligensens av den blå.

Det går att föra samman Mollicks tankar om AIs ojämna kant med Vygotskijs proximala utvecklingszon, en sammansmältning som innebär att det inte längre är en mänsklig mentor som guidar utan en stor språkmodell.

Men till skillnad från en mänsklig pedagog eller mentor som kan möta mig där jag just nu befinner mig har de stora språkmodellerna ingen egen agens, särskilt inte när vi använder dem i generella chattbotar som ChatGPT och Claude. Inbyggda i mer skräddarsydda lösningar kan de fått tydliga instruktioner, men i en öppen konversation kommer de att svara på det sätt som jag ber om. Promptar jag för oprecist och sparsmakat är risken stor att svaret kommer att hoppa över alla lärande steg på vägen och gå rakt på en beskrivning som är mycket mer komplex än jag har möjlighet att ta till mig.

Istället behöver jag göra det tydligt i mina instruktioner att jag vill bli “mött” strax utanför där min nuvarande kunskap tar slut, i min proximala utvecklingszon, för att steg för steg närma mig en mer fullständig och komplex förståelse.

Men det här kompliceras av att språkmodellen inte vet var gränsen för min förståelse går och att jag som användare inte enkelt kan avgöra var modellen har sina begränsningar.

Vygotskijs teori beskriver idealet — stegvis lärande precis bortom min nuvarande förmåga. Mollicks teori beskriver utmaningen när jag använder språkmodeller för att lära nytt — de vet inte vad jag redan kan.

Att flyga med rumpan #

AI-Generated “Workslop” Is Destroying Productivity lyder rubriken på en text i Harvard Business Review som delats flitigt i mina flöden och som bland annat beskriver den utmaningen. Texten argumenterar för att man ska sträva efter att vara en pilot och inte en passagerare i sin användning av generativ Al:

Pilots are much more likely to use AI to enhance their own creativity, for example, than passengers. Passengers, in turn, are much more likely to use AI in order to avoid doing work than pilots. Pilots use AI purposefully to achieve their goals.

Jämförelsen mellan piloter och passagerare påminde mig om en text jag skrev i Forskning och Framsteg november 2011. Den handlar om riskerna med för mycket automatisering, med just flyg som exempel: Ska du bli en bra pilot som kan fatta svåra beslut under tidspress i oväntade situationer kan du inte fram till den stunden helt ha förlitat dig på autopiloten. “Det finns ett gammalt klassiskt pilotuttryck som säger att man ska lära sig att ‘flyga med rumpan’,” säger en av personerna som är citerad i artikeln. Det handlar om att ha stötts och blötts med tekniken under många, många timmar för att ha känt i rumpan hur planet beter sig i olika situationer. Först då får man tillräckligt mycket intuitiv känsla för den underliggande tekniken för att kunna ta över om automationen fallerar.

Jag har under åren refererat till den texten i många intervjuer, för att via de resonemangen komma in på vad som händer i olika branscher i takt med att automationsgraden ökar. Hur säkerställa att avgörande kunskap över tid inte går förlorad för att för få människor kan utföra arbetsuppgifterna?

Med genombrottet för generativ AI är den frågeställningen relevant även på ett individuellt plan. Hur ser jag till att använda språkmodellerna på ett sätt som inte automatiserar bort mina möjligheter att lära mig det jag behöver kunna?

Små steg mot ny kunskap #

Som användare av stora språkmodeller blir vi hjälpta av att förhålla oss till både Vygotskijs och Mollicks teorier. Vi behöver dels förstå inom vilka områden de faktiskt är bättre än oss, dels hur vi bäst utnyttjar modellerna när vi vill att de ska hjälpa oss i vårt lärande. Överfört till användningen av en språkmodell och Mollicks idé om en ojämn kant finns den proximala utvecklingszonen i utrymmet mellan det jag själv kan och den kunskap som finns representerad i modellen.

I Hard Fork-avsnittet fortsätter studenten med ett resonemang som är en bra beskrivning av hur jag själv upplevt att modellerna hjälpt mig bygga kunskap och förståelse inom olika ämnesområden som jag ger mig ut i:

I found AI to be really helpful for connecting the dots between different moments of clarity that you might have gotten when you were sitting in lecture or were focused and then unfocused one time. So you use AI to fill in the gaps between when you lost focus or lost understanding.

Utmaningen är att min proximala utvecklingszon inte utgörs av hela utrymmet mellan vad jag kan och vad modellen kan utan bara av den del som ligger precis utanför min egen förmåga. Därför är det viktigt att försöka att prompta modellen så att den successivt ger mig hjälp att flytta min förståelse framåt, istället för att direkt ge det korrekta svaret.

Min erfarenhet är att stora kunskapsgap kräver mer noggrant promptande för att modellen bättre ska “förstå” på vilken nivå den ska lägga sig för att bäst hjälpa mig. “Förklara X så att en 10-åring förstår” är ju ett vanligt exempel på hur man kan få språkmodeller att förenkla komplexa begrepp, men den prompten är för svepande för att fungera bra.

Så in med Vygotskij i systemprompten! #

Här någonstans smälter tankar och teorier om proximala utvecklingszoner, ojämna kanter och flygande med rumpan ihop, på både individ- och systemnivå: Hur hittar vi sätt att utnyttja språkmodellerna för att ta oss framåt utan att samtidigt undergräva vår egen förståelse och därmed också möjlighet att utvecklas?

Ett praktiskt tillvägagångssätt för mig har blivit ett nytt tillägg i min mest använda systemprompt, den som instruerar språkmodellerna att agera som ett bollplank. Den innehåller sen ett tag tillbaka följande instruktion:

Meet me where I am (Vygotsky's theory of zone of proximal development): Gauge my understanding from what I write. If unclear, ask one question about my current knowledge level, then proceed.

Men en följdfråga återstår: Hur vet jag när jag hamnat fel i relation till den ojämna kanten, för långt från min egen förmåga och för nära modellens? Går det att fånga också det i en instruktion i prompten?